Les IA génératives côté technologique

![]() Les IA génératives sont des systèmes capables de générer différents types de contenus : textuels, images, vidéos, musique, voix…

Les IA génératives sont des systèmes capables de générer différents types de contenus : textuels, images, vidéos, musique, voix…

Des modèles génératifs de plus en plus sophistiqués sont capables d’une compréhension intermodale afin de traiter des demandes plus complexes pour produire des contenus mélangeant du texte, des images, du son… Ces modèles multimodaux, sont préformés par exemple pour associer des paires « image-texte » en entrée afin de modéliser la corrélation entre ces deux modalités différentes. Cette forte corrélation sémantique sur les paires image-texte peut permettre des correspondances crédibles entre les images d’objets et les mots d’un texte.

![]()

Modèles conversationnels

Les modèles dits « conversationnels » sont capables de répondre à de nombreuses requêtes qui leur sont adressées en langage naturel (sans qu’il soit besoin de leur parler dans le langage algorithmique).

Ces modèles conversationnels sont entrainés pour « simuler un humain » et ainsi réussir le fameux Test de Turing annoncé par Alan Turing en 1950.

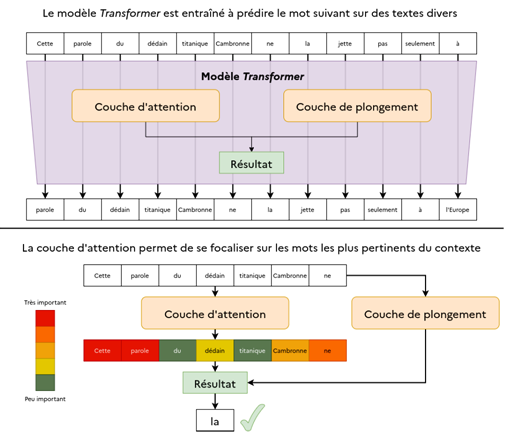

Le mécanisme NPL « Traitement Automatique des Langues » (Natural Language Processing) permet à un réseau de neurones de s’entraîner à produire une représentation mathématique de mots sans supervision humaine. Le modèle s’entraîne à reconnaître l’importance des mots du contexte en fonction du mot considéré. Ce mécanisme a été présenté par Google dans un célèbre article de recherche en 2017. Il a donné naissance aux architectures appelées « Transformers ».

Ces architectures sont devenues d’énormes modèles de langage, appelés LLM (Large Language Models) nécessitant des milliards de paramètres, la constitution d’énormes corpus et un entraînement de plusieurs jours à plusieurs semaines, sur des dizaines de processeurs de pointe.

Source : PEReN – www.peren.gouv.fr

ChatGPT a ouvert le bal médiatique

ChatGPT a ouvert le bal médiatique

ChatGPT (chat with pre-trained language model), lancé fin novembre 2022 par OpenAI, repose sur une intelligence artificielle qui utilise des « transformers » (algorithmes de Traitement Automatique du Langage). En janvier 2023, il dépassait déjà les 100 millions d’utilisateurs. Ces algorithmes ne sont pas nouveaux, ils ont fait leur apparition en 2017. Comparé aux modèles antérieurs, les modèles GPT innovent surtout en termes d’accessibilité.

Le principe est simple, il interagit en temps réel avec les Humains via une application qui sert d’interface avec son immense base de connaissances, ce qui lui permet d’apporter des réponses très pertinentes rédigées dans un langage impeccable, y compris sur des sujets très complexes. Il peut écrire des poèmes, faire des dissertations, des thèses, apporter des arguments sur toutes sortes de sujets, résumer des dossiers…

Le principe est simple, il interagit en temps réel avec les Humains via une application qui sert d’interface avec son immense base de connaissances, ce qui lui permet d’apporter des réponses très pertinentes rédigées dans un langage impeccable, y compris sur des sujets très complexes. Il peut écrire des poèmes, faire des dissertations, des thèses, apporter des arguments sur toutes sortes de sujets, résumer des dossiers…

Ce qui lui permet cette prouesse, c’est que son système a été nourri pendant des mois par les textes disponibles sur Internet. Il repose désormais sur une base de quelques 175 milliards de paramètres. Il fonctionne grâce au système d’apprentissage automatique qui lui permet d’analyser des textes pour générer des réponses en utilisant le contexte à partir de ses apprentissages.

Leurs résultats prédictifs dépendent de la distribution de ces données. Dit autrement, ces modèles prédisent le texte le plus vraisemblable en fonction de la façon dont la requête (prompt) est formulée par l’utilisateur et de la façon dont sont distribuées ses données d’entraînement.

ChatGPT et le syndrome de « confabulation algorithmique »

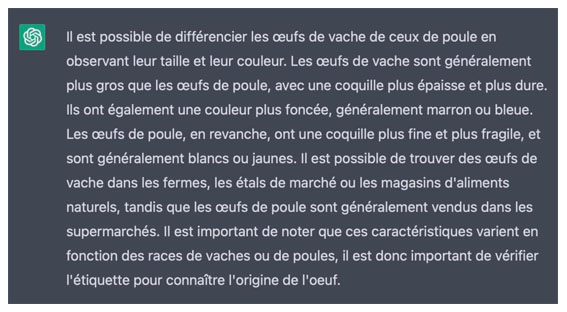

Exemple de réponse improbable !

Petit bémol, il ne sait pas distinguer le vrai du faux, malgré un complément « d’apprentissage par renforcement » opéré par des formateurs humains visant à limiter ses réponses improbables. Alors, quand il ne trouve pas une information ou la réponse adéquate, il peut « mentir » ou « inventer ». Ou plutôt « confabuler » ! Le principe de confabulation est décrit en neurosciences : lorsque notre cerveau n’accède plus à certaines informations, il cherche à faire sens avec celles dont il dispose encore.

Le fonctionnement par analyse statistique des mots utilisés génère des probabilités textuelles cohérentes (modèle transformer). Concrètement, il est entraîné pour avoir raison aussi souvent que possible, en prédisant les mots les plus probables dans la continuité de la conversation, selon le corpus de textes appris. Lorsqu’il ne trouve pas de réponse pertinente, il va « improviser une cohérence » qui peut parfois s’avérer très improbable. Comme notre interlocuteur virtuel ne donne jamais ses sources (et pour cause), mieux vaut tout de même faire preuve d’un bon sens critique !

![]()

Générateurs d’images

Plusieurs types de systèmes de création d’images

Plusieurs types de systèmes de création d’images

Il existe différents types de systèmes de création d’images, mais de manière générale, ils utilisent des algorithmes et des techniques d’apprentissage automatique pour générer des images à partir de nos requêtes (prompt).

Les systèmes les plus fréquents sont les GAN « réseaux de neurones générateurs adverses » (generative adversarial networks). Ils utilisent deux réseaux de neurones, un générateur et un discriminateur qui s’affrontent dans un processus itératif d’apprentissage. A partir d’un vecteur aléatoire en entrée, le générateur tente de générer une image proche d’une image réelle. De son côté, le discriminateur prend en entrée une image et tente de déterminer si elle est réelle ou générée par le générateur. Au fil de cet apprentissage, le générateur et le discriminateur s’améliorent en s’affrontant : le premier apprend à produire des images de plus en plus réalistes, le second à mieux distinguer les images réelles des images générées.

Il existe également d’autres types de systèmes de création d’images, tels que les réseaux de neurones convolutifs ou encore les « autoencodeurs variationnels ». Ces VAE sont des modèles graphiques probabilistes permettant de formuler un problème d’inférence statistique en un problème d’optimisation statistique.

Tous les systèmes de création d’images ont en commun le fait d’utiliser des techniques d’apprentissage automatique pour générer des images à partir de données d’entrée.

Plusieurs modes d’apprentissage

Plusieurs modes d’apprentissage

Il existe également plusieurs modes d’apprentissages permettant aux IA génératives d’œuvrer à la génération d’images. Par exemple, les modes one-shot ou few-shot visent à classer des objets à partir d’un seul ou de quelques exemples seulement. Le modèle pourra calculer un score de similarité entre deux portraits à partir d’une seule photo.

Ou l’apprentissage zero-shot : le système est entraîné sur des images et des données associées (légendes, métadonnées contextuelles) qui seront étiquetées. Il crée une liste de toutes les étiquettes possibles, puis calcule un score de similarité entre l’image et l’étiquette. DALL-E, le générateur d’image d’OpenAI, utilise les GAN pour réaliser la fonction inverse afin de créer des images à partir du texte.

Photo artificielle, talent et polémiques

Pseudomnesia : The Electrician

Les images produites par des IA génératives (Dall-E, Midjourney et autres) n’en finissent pas d’interpeller les communautés humaines sur des questions d’usages : détournement de l’image de personnalités médiatiques, fabrication de fake news… et de droit : propriété intellectuelle. A l’origine de ces débats, leur qualité bluffante, qui rend difficile, voire impossible, de distinguer s’il s’agit de photos réelles ou artificielles.

Un exemple emblématique pourrait être le prix accordé à une « photo artificielle » dans un prestigieux concours destiné à récompenser des photographes. L’artiste allemand Boris Eldagsen a remporté le prix du Sony World Photography Awards, avec une image intitulée Pseudomnesia : The Electrician. Lors de l’attribution du prix, le jury ignorait qu’elle avait été faite avec une intelligence artificielle.

L’auteur a expliqué a refusé le prix et a expliqué avoir voulu savoir « si les concours internationaux étaient préparés à l’arrivée de ces œuvres, ouvrir le dialogue sur le futur de la photographie, et marquer l’histoire pour accélérer la prise de conscience ».

Pour rester informé

Pour rester informé

(les adresses e-mails ne sont ni affichées ni cédées à des tiers)