Stratégie numérique pour l’Europe

La stratégie numérique pour l’Europe pour la décennie 2020-2030 veut répondre au développement rapide et généralisé des plateformes de services numériques, aux questions sur les technologies telles que l’intelligence artificielle en créant des espaces et des services numériques sûrs, une égalité de concurrence avec les grandes plateformes sur les marchés numériques. Mais aussi renforcer la souveraineté numérique de l’Europe, tout en contribuant à l’objectif de neutralité climatique d’ici 2050.

« Façonner l’avenir numérique de l’Europe » est une stratégie établie en 2020, axée sur trois objectifs : la technologie au service des personnes, une économie juste et compétitive, ainsi qu’une société durable et démocratique. Cette stratégie a été complétée en 2021, par la boussole numérique : l’Europe balise la décennie numérique, qui porte sur 10 ans et traduit les ambitions de l’Union à l’horizon 2030 en objectifs concrets.

Quelles lois européennes pour l’Intelligence Artificielle ?

![]()

Création de l’AI Office

Création de l’AI Office

La Commission Européenne a créé un « Bureau de l’IA » pour veiller sur le Futur de l’intelligence artificielle en Europe et sa régulation (notamment l’A IAct).

Objectif : « permettre le développement, le déploiement et l’utilisation futurs de l’IA favorisant les avantages sociétaux, économiques et l’innovation, tout en atténuant les risques »

Cinq « unités » composent l’AI Office :

– Réglementation et conformité

– Sécurité de l’IA

– Excellence de l’IA et de la robotique

– L’IA au service du bien sociétal

– Innovation et coordination des politiques

L’AI Act

Décryptage de l’AI Act par la CNIL

Décryptage de l’AI Act par la CNIL

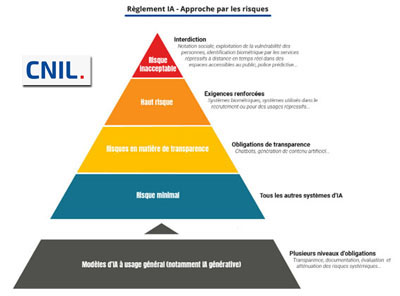

Après la publication de l’AI Act au JOUE (Journal Officiel de l’UE), la CNIL (Commission nationale informatique et libertés) en propose un décryptage. Déjà en charge du respect du RGPD (Règlement général pour la protection des données), réglementation applicable à tous les systèmes informatiques, elle l’est donc aussi concernant les données personnelles traitées pour ou par les systèmes d’IA.

Les 4 niveaux de risques

1️⃣ Risque inacceptable : il interdit un ensemble limité de pratiques contraires aux valeurs de l’UE et aux droits fondamentaux

2️⃣ Haut risque : il définit les Systèmes d’IA comme étant à haut risque lorsqu’ils peuvent porter atteinte à la sécurité des personnes ou à leurs droits fondamentaux, ce qui justifie que leur développement soit soumis à des exigences renforcées

3️⃣ Risque minimal : il ne prévoit pas d’obligation spécifique pour tous les autres Systèmes d’IA

4️⃣ Systèmes dits « à usage général », notamment dans le domaine de l’IA générative, difficiles à classer dans les catégories précédentes. Ils se définissent par leur capacité à servir à un grand nombre de tâches, comme les LLM (grands modèles de langage).

Étapes de L’AI Act, loi européenne sur l’intelligence artificielle

Étapes de L’AI Act, loi européenne sur l’intelligence artificielle

16 mai 2024 : publication du texte définitif du Règlement européen sur l’IA avec une Table des Matières interactive. Le document est un outil utile pour les personnes concernées par cette réglementation européenne. Il offre « une vue d’ensemble de la structure du Règlement, permettant aux utilisateurs d’être redirigés d’un simple clic vers les différents titres, chapitres et articles ».

8 décembre 2023 : Accord historique du trilogue : Commission européenne, Parlement européen et Conseil de l’Europe

L’Union Européenne est ainsi le premier continent doté d’un cadre juridique complet concernant l’intelligence artificielle : objectif, réguler sans brider l’innovation en Europe.

14 juin 2023 : Adoption par le Parlement européen de « L’AI Act », projet de loi européenne visant à établir des règles harmonisées en Europe, pour une IA de confiance, centrée sur l’humain. Les législateurs de l’UE ont opté pour une approche à plusieurs niveaux distinguant les modèles d’Intelligence Artificielle à « usage général » et les modèles « d’IA générative » comme les grands modèles de langage (ChatGPT) avec un régime plus strict.

L’approche est basée sur la notion de risques :

– Risque inacceptable : interdiction

– Haut risque : systèmes soumis à un ensemble d’exigences et d’obligations pour accéder au marché de l’UE

– Risque imité : soumise à des obligations de transparence (par exemple : mentionner « réalisé par une IA »

A noter que le texte un renforcement du droit de déposer plainte et de recevoir des explications sur les décisions basées sur les systèmes d’IA.

Pour stimuler l’innovation, des exemptions ont été ajoutées pour les activités de recherche et les composants d’IA fournis sous des licences #opensource. La loi promeut des « bacs à sable réglementaires » établis par les pouvoirs publics pour tester l’IA avant déploiement.

Première étape de l’AI Act

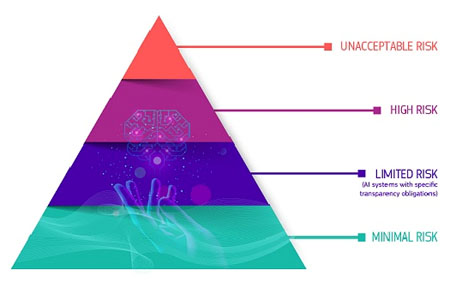

Au stade de proposition, The Artifical Intelligence Act (AI act), prévoit de classer les applications de l’IA dans quatre catégories de risques :

Au stade de proposition, The Artifical Intelligence Act (AI act), prévoit de classer les applications de l’IA dans quatre catégories de risques :

– Risque inacceptable : les applications et les systèmes tels que la notation sociale – social rating – utilisée par le gouvernement chinois) sont interdits

– Risque élevé : les systèmes d’IA utilisés dans des infrastructures critiques : la formation scolaire ou professionnelle, les composants de sécurité des produits, l’emploi, la gestion des travailleurs et l’accès au travail indépendant, l’application de la loi susceptible d’interférer avec les droits fondamentaux des personnes, l’administration de la justice et processus démocratiques.

– Risque limité : les systèmes faisant référence à des obligations de transparence spécifiques.

– Risque minime ou nul : comme les applications telles que les jeux vidéo compatibles avec l’IA ou les filtres anti-spam.

Une approche européenne axée sur la confiance et l’excellence

Globalement, l’approche de l’Union Européenne concernant l’intelligence artificielle veut s’axer sur l’excellence et la confiance, pour stimuler la recherche et la capacité industrielle et à garantir les droits fondamentaux.L’objectif est de renforcer le potentiel de l’Europe en matière de concurrence à l’échelle mondiale.

Pour construire une IA digne de confiance et créer un environnement sûr et propice à l’innovation pour les utilisateurs et les développeurs, la Commission a proposé trois initiatives juridiques interdépendantes :

– Un cadre juridique européen afin de faire face aux risques liés aux droits fondamentaux et à la sécurité propres aux systèmes d’IA,

– Les règles de l’UE visant à résoudre les problèmes de responsabilité liés aux nouvelles technologies, y compris les systèmes d’IA (dernier trimestre 2021 – 1er trimestre 2022),

– Une révision de la législation sectorielle en matière de sécurité (par exemple, règlement sur les machines, directive sur la sécurité générale des produits, deuxième trimestre 2021).

Le Digital Services Act

Entrée en vigueur du Digital Services Act (DSA)

Entrée en vigueur du Digital Services Act (DSA)

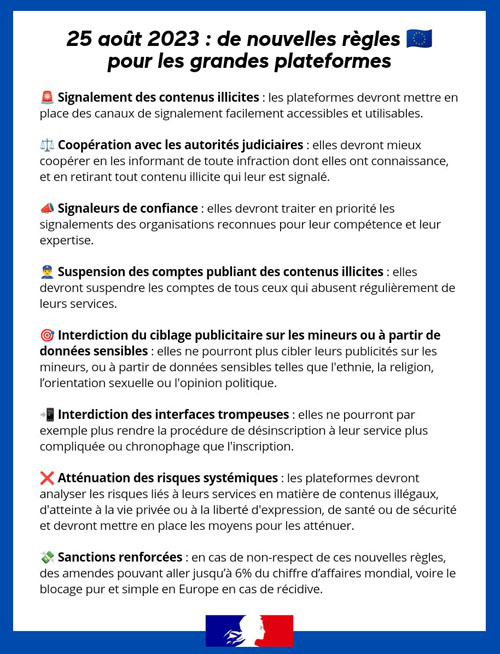

25 août 2023, entrée en vigueur du Digital Services Act, la réglementation européenne concernant les services numériques.

– 19 très grandes plateformes sont concernées : Alibaba, Amazon, Apple, Booking.com, Facebook, Google Play, Google Maps, Google Shopping, Instagram, LinkedIn, Pinterest, Snapchat, TikTok, Wikipedia, X (ex Twitter), YouTube, Zalando.

Ces entreprises doivent se conformer à de nouvelles obligations visant à autonomiser et à protéger les utilisateurs en ligne, dont les mineurs.

Parmi leurs obligations, les plateformes doivent désormais proposer aux internautes un outil pour signaler facilement les contenus « illicites », puis les retirer rapidement.

Parmi les mesures en cas de non-respect de la réglementation : des amendes jusqu’à 6 % de leur chiffre d’affaires mondial et le risque d’interdiction en Europe (soit environ 45 millions d’utilisateurs mensuels).

Publication du DSA, règlement européen sur les services numériques

Publication du DSA, règlement européen sur les services numériques

Pour une responsabilisation des plateformes

Novembre 2022 : Le DSA (Digital Services Act), règlement sur les services numériques vise notamment à encadrer les activités des plateformes, en particulier celles des GAFAM.

Novembre 2022 : Le DSA (Digital Services Act), règlement sur les services numériques vise notamment à encadrer les activités des plateformes, en particulier celles des GAFAM.

Ses objectifs :

– Mettre en pratique le principe selon lequel ce qui est illégal hors ligne est illégal en ligne

– Responsabiliser les plateformes numériques et lutter contre la diffusion de contenus illicites ou préjudiciables ou de produits illégaux : attaques racistes, images pédopornographiques, désinformation, vente de drogues ou de contrefaçons

– Mieux protéger les internautes européens et leurs droits fondamentaux (liberté d’expression, protection des consommateurs…)

– Aider les petites entreprises de l’UE à se développer

– Renforcer le contrôle démocratique et la surveillance des très grandes plateformes

– Atténuer des risques systémiques, tels que la manipulation de l’information ou la désinformation

Des finalités :

=> Lutte contre les contenus illicites : proposer aux internautes un outil leur permettant de les signaler facilement et retrait rapide ou blocage des accès

=> Transparence en ligne :

– Rendre plus transparentes les décisions en matière de modération des contenus

– Expliquer le fonctionnement des algorithmes de recommandation de contenus publicitaires

=> Interdiction de la publicité ciblée pour les mineurs, de même que celle basée sur des données sensibles comme la religion ou l’orientation sexuelle

Il s’applique dans tous les pays de l’UE. Un « coordinateur des services numériques », autorité indépendante désignée par chaque État membre, sera mis en place. En cas de non-respect, des amendes (pouvant aller jusqu’à 6% du chiffre d’affaires mondial des plateformes seront infligées, et en cas de violations graves et répétées elles pourront se voir interdire leurs activités sur le marché européen.

Prises de positions de l’Europe en matière d’Intelligence Artificielle

Quelques textes concernant la place et l’éthique des Intelligences Artificielles et les potentielles responsabilités concernant les technologies émergentes et/ou autonomes :

![]() Avril 2021 – Proposal for a Regulation on a European approach for Artificial Intelligence

Avril 2021 – Proposal for a Regulation on a European approach for Artificial Intelligence

La commission européenne a publié son projet de réglementation et d’actions « en faveur de l’excellence et de la confiance dans l’intelligence artificielle » qui distingue plusieurs niveaux de risque pour les systèmes d’IA.

La commission européenne a publié son projet de réglementation et d’actions « en faveur de l’excellence et de la confiance dans l’intelligence artificielle » qui distingue plusieurs niveaux de risque pour les systèmes d’IA.

Les systèmes d’IA : à risque minime, à risque limité, à risque élevé. Il propose des règles spécifiques pour les fournisseurs de systèmes d’IA à haut risque : Pour être mis sur le marché, un système d’IA à haut risque doit notamment faire l’objet d’une évaluation de sa conformité. Les systèmes d’IA autonomes doivent être enregistrés dans une base de données de l’UE pour recevoir une déclaration de conformité portant le marquage CE. S’ils subissent des modifications substantielles au cours de leur cycle de vie, ils doivent revenir à l’étape d’évaluation de leur conformité.

![]() Août 2020 – Le Comité économique et social européen a rendu son avis sur le Livre blanc de la Commission européenne sur l’IA

Août 2020 – Le Comité économique et social européen a rendu son avis sur le Livre blanc de la Commission européenne sur l’IA

Le CESE invite notamment la Commission européenne « à jouer un rôle de chef de file afin d’assurer, en Europe, une meilleure coordination des solutions et approches relevant de l’IA appliquée qui sont utilisées pour lutter contre la pandémie de coronavirus ».

![]() Février 2020 – Livre blanc : « Intelligence artificielle, une approche européenne axée sur l’excellence et la confiance »

Février 2020 – Livre blanc : « Intelligence artificielle, une approche européenne axée sur l’excellence et la confiance »

Extrait : « Pour tirer le meilleur parti possible des opportunités qu’offre l’IA et relever les défis qu’elle pose, l’UE doit se montrer unie dans l’action et définir une manière qui lui est propre de promouvoir le développement et le déploiement de l’IA, en s’appuyant sur les valeurs européennes ».

![]() Février 2020 – Rapport « Liability for Artificial Intelligence and other emerging digital technologies » Quelle responsabilité pour l’intelligence artificielle ? Mis en place dès 2018 par la Commission européenne, un groupe d’experts vient de livrer un rapport sur la responsabilité appliquée à l’IA et aux technologies émergentes. Il présente une dizaines de recommandations.

Février 2020 – Rapport « Liability for Artificial Intelligence and other emerging digital technologies » Quelle responsabilité pour l’intelligence artificielle ? Mis en place dès 2018 par la Commission européenne, un groupe d’experts vient de livrer un rapport sur la responsabilité appliquée à l’IA et aux technologies émergentes. Il présente une dizaines de recommandations.

![]() Février 2020 – Publication d’une « Stratégie européenne pour les données »

Février 2020 – Publication d’une « Stratégie européenne pour les données »

Extrait : « L’UE peut devenir un modèle de premier plan pour une société à laquelle les données confèrent les moyens de prendre de meilleures décisions, tant dans les entreprises que dans le secteur public. Afin de réaliser cette ambition, l’UE peut s’appuyer sur un cadre juridique fort (en termes de protection des données, de droits fondamentaux, de sûreté et de cybersécurité) ».

Pour rester informé

Pour rester informé

(les adresses e-mails ne sont ni affichées ni cédées à des tiers)