Faut-il vraiment « appairer Éthique et Intelligences Artificielles » ?

– Hi, cKiou s’étonne de cette question ! Il semble évident de répondre « oui, bien sûr » ! Quel Humain pourrait refuser ce qui permet de rendre sa société vivable ? Parce que, déjà dans l’Antiquité, les philosophes Aristote et Kant disaient de l’éthique qu’elle « définit ce qui doit être ». Et depuis, l’éthique interroge sur les comportements à adopter pour rendre la société humainement vivable. Donc ça vaut le coup, non ?

– Hi, cKiou s’étonne de cette question ! Il semble évident de répondre « oui, bien sûr » ! Quel Humain pourrait refuser ce qui permet de rendre sa société vivable ? Parce que, déjà dans l’Antiquité, les philosophes Aristote et Kant disaient de l’éthique qu’elle « définit ce qui doit être ». Et depuis, l’éthique interroge sur les comportements à adopter pour rendre la société humainement vivable. Donc ça vaut le coup, non ?

– Certes cKiou…mais c’est moins évident qu’il n’y parait ! Même si nous allons voir maintenant que l’éthique des Intelligences Artificielles sera à coup sûr l’un des grands défis de la société du XXIè siècle, des difficultés se dressent devant cette évidence. Ces dernières années, l’IA a proliféré dans une course à l’euphorie de la découverte, mais sans vraiment se poser de questions, les yeux rivés sur le guidon d’avancées en cascade et de business à développer. De fait, l’IA a investi tous les recoins de la société en la mettant devant le « fait accompli », usages après usages. Alors l’idée de devoir maintenant changer les us et coutumes suscite des réticences côté concepteurs (certains préférant continuer à développer à l’abri des regards), et ne s’entend pas que de gaité de cœur côté utilisateurs qui ne perçoivent pas spontanément les impacts délétères sur certains usages (captologie). Autre obstacle, et non des moindres, les différences culturelles sur les valeurs humaines, les notions de « bien ou mal » pour la société (reconnaissance faciale).

Intelligences Artificielles et Éthique… appairage à réussir !

Éthique : des comportements à adopter pour rendre la société humainement vivable,

le grand défi de la société du XXIè siècle

Ne pas confondre « éthique » et « législation »

Ne pas confondre « éthique » et « législation »

Disons-le tout de suite, l’Éthique n’est pas le Droit : elle est le fruit d’une pensée collégiale reposant sur des valeurs humaines, autour des avancées technologiques, pour que celles-ci soient bénéfiques à la société et non l’inverse.

L’éthique est donc la réflexion qui permet une prise de conscience collective, et un positionnement sur l’éventuelle nécessité d’interdire ou d’encadrer des pratiques rendues possibles par les technologies d’Intelligences Artificielles. Elle doit également permettre de guider les différents praticiens et donneurs d’ordres quant à leurs projets et démarches, et si besoin leur permettre de définir des limites à ne pas franchir.

Dans tous les domaines sociétaux, c’est cette approche du « bien » et du « mal » au sens défini par Spinoza : « ce qui sert ou nuit à la conservation de notre être », qui permet d’établir la règle qui va entrer dans le domaine du droit.

![]() L’éthique doit se pencher sur l’ensemble des risques sociétaux rendus possibles par les outils et services algorithmés. Objectif, proposer si besoin un cadre légal adapté.

L’éthique doit se pencher sur l’ensemble des risques sociétaux rendus possibles par les outils et services algorithmés. Objectif, proposer si besoin un cadre légal adapté.

Deux axes pour une IA éthique : process et usages

Aux difficultés existentielles à l’appairage « IA – Éthique », on peut ajouter une difficulté très concrète : l’éthique doit trouver sa place sur deux axes distincts mais insécables ses « process et usages ».

Par « process », entendons l’écriture algorithmique, et par « usages » la façon dont les IA entrent dans la vie des Humains et leurs finalités : ce qu’ils vont pouvoir y faire et ce qu’il vaudrait mieux qu’ils ne fassent pas.

L’écriture algorithmique renferme des biais : par exemple, nous avons certainement tous entendu parler de biais récurrents au sein de dispositifs d’embauche, désormais très utilisés pour faire remonter les meilleurs CV sur les bureaux des recruteurs. Ce sont des systèmes performants, mais dont certains se sont révélés discriminants sur l’ethnie et/ou le genre des candidats. De fait, des outils de « testing algorithmique » se développent et sont désormais disponibles afin de détecter ce type de discriminations à l’embauche.

Typologie des risques potentiels avant éthique !

– Risque systémique d’atteinte à la vie privée

– Risque d’opacité des systèmes, difficulté d’auditabilité

– Risque lié à la liberté et la sécurité des personnes

– Risque sociétal, biais et mésusages

L’écriture algorithmique : biais et transparence

A propos des biais potentiels de l’IA, Yann LeCun (Prix Turing 2018, Directeur de la recherche fondamentale en IA chez Facebook) a raison lorsqu’il tweete que les biais sont généralement le fruit de défauts humains, qu’ils soient liés à des erreurs, des lacunes ou autres raisons. Il n’en reste pas moins que leurs conséquences systémiques peuvent être extrêmement dommageables pour les Humains.

Il a encore raison en disant que les biais dans les données peuvent être corrigés. Deux conditions cependant :

– que les donneurs d’ordres soient déterminés à prendre en compte la dimension éthique et que les concepteurs soient formés pour.

– que les systèmes ne soient pas enfermés dans des « boites noires » difficiles d’accès.

Il n’est pas certain que cela puisse se faire sans prises des positions éthiques claires et affirmées, car comme le dit aussi Yann LeCun : « les biais des individus sont parfois difficiles à corriger » !

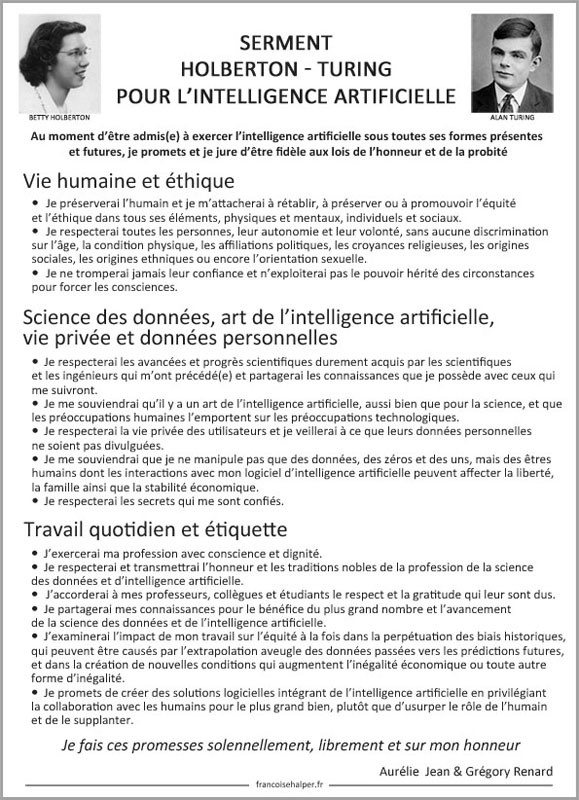

Un « serment d’Hippocrate » vs Intelligences Artificielles

Conscients des enjeux sociétaux, en juin 2018, deux experts en Intelligences Artificielles : Aurélie Jean (computational scientist) et Grégory Renard (Chief AI Officer xBrain), ont proposé que soit établi un « socle commun de principes déontologiques ou de morale philosophique concernant les Etats, les organisations institutionnelles et privées, les scientifiques et plus généralement tous ceux qui œuvrent dans le milieu de l’intelligence artificielle ». Ils l’imaginent sous la forme d’un « serment d’Hippocrate » vs Intelligences Artificielles qu’ils baptisent « serment Holberton-Turing » (du nom de deux grandes figures de l’histoire de l’IA). Serment qui engagerait moralement chaque acteur de l’IA sous toutes ses formes et à tous niveaux.

L’enjeu d’un engagement éthique est double : éviter de renforcer les injustices sociétales et éviter d’en créer de nouvelles

Peut-on rendre l’écriture algorithmique transparente ?

– Hi, cKiou se demande si maintenant on peut concrètement rendre l’IA transparente ? Parce qu’en mai 2018 on avait étudié cette question et elle semblait complexe. cKiou n’est pas sûre que les choses aient beaucoup avancé. Alors concrètement, on peut ou on peut pas ?

– Hi, cKiou se demande si maintenant on peut concrètement rendre l’IA transparente ? Parce qu’en mai 2018 on avait étudié cette question et elle semblait complexe. cKiou n’est pas sûre que les choses aient beaucoup avancé. Alors concrètement, on peut ou on peut pas ?

– Tu as raison cKiou, la toute première question est celle de la faisabilité. Il ne faudrait pas que les bonnes intentions ne relèvent que de ce truc très humain : le « ya-ka-fo-kon » 😉 !

Alors, oui, il y a quelques 18 mois, on avait abordé la question de la transparence des algorithmes. Sans être véritablement en avance de phase, la question était alors moins prégnante qu’aujourd’hui. On est face à une croissance exponentielle des systèmes algorithmés. Si les principes sont les mêmes, le cadre technologique évolue à la vitesse de l’éclair ! Machine Learning et Deep Learning « maturent » chaque jour davantage, prouesses et conséquences technologiques à la clé.

Interprétabilité et Explicabilité des algorithmes

Les praticiens de l’IA savent rendre « interprétables » les systèmes de Machine Learning. C’est un peu plus complexe pour le Deep Learning qui dépasse les formes analytiques simples de son frère aîné. Lui n’est donc pas nativement interprétable. Pour ces systèmes dits d’apprentissage profond, le chemin de la transparence passe par l’explicabilité, c’est-à-dire, schématiquement, la capacité d’identifier au fur et à mesure les variables qui conduisent aux résultats.

Il n’est pas impossible d’offrir de la transparence à l’écriture algorithmique !

De plus, conscient des problèmes de confiance dus à l’opacité native des algorithmes, opacité freinant actuellement l’adoption des Intelligences Artificielles par les entreprises, un grand acteur du secteur a lancé fin 2018 une solution logicielle ouverte capable de détecter certains biais et d’expliquer en temps réel les processus algorithmiques.

Quelles que soient les façons de procéder, il importe de mettre en place des protocoles de transparence d’une part, et d’autres permettant de rechercher la sensibilité des algorithmes aux biais que l’on veut éviter (en fonction du secteur et des objectifs visés), et ce tout au long du processus d’écriture algorithmique.

Éthique des usages et finalités des Intelligences Artificielles

Au-delà des attentes en termes de transparence et de correction des biais potentiels, l’éthique doit se pencher sur la façon dont sont préservées les données personnelles qui nourrissent les systèmes algorithmés et les usages auxquels on destine leurs applications.

– Hi, cKiou se demande si les Humains ne devraient pas confier la question de l’éthique à une IA pour savoir si la finalité de tel ou tel système va vraiment « rendre la société humainement vivable » ! Qu’est-ce que tu en penses ?

– Hi, cKiou se demande si les Humains ne devraient pas confier la question de l’éthique à une IA pour savoir si la finalité de tel ou tel système va vraiment « rendre la société humainement vivable » ! Qu’est-ce que tu en penses ?

– Malheureusement cKiou, l’Humanité n’est pas binaire, ce serait trop simple ! Du coup, le « privilège » de cette réflexion incombe aux seuls Humains. A eux de résoudre la complexité générée par des valeurs, des cultures, des intérêts parfois très différents et bien souvent contradictoires, voire clivants.

Deux exemples de questions éthiques clivantes

La reconnaissance faciale

Le premier exemple est donné par la « reconnaissance faciale », aujourd’hui au centre de débats contradictoires. L’Intelligence Artificielle donne à ces systèmes de grandes possibilités : authentification, cybersurveillance, criminologie… Mais c’est aussi un outil qui permet des usages attentatoires au respect de la vie privée et peut être utilisé à des fins peu démocratiques au sens où nous l’entendons dans nos cultures.

Sur le plan de la vie privée, les mésusages comme les manipulations d’images, peuvent tomber sous le coup de la loi. Par contre, à défaut de prise de position éthique consensuelle, aucun cadre légal n’est encore officiellement donné à la reconnaissance faciale pour des usages publics.

Des voix s’élèvent actuellement pour appeler à réfléchir et à poser des bases éthiques afin de définir une régulation adaptée, mais elles ne sont pas à l’unisson. Exemple, celles des patrons de Google et de Microsoft : le premier appelant à une réglementation stricte, le second à une réglementation nettement plus light.

La captologie

Autre exemple, celui des systèmes de captologie. L’objectif de ces systèmes algorithmés est de modifier à notre insu nos comportements face aux outils digitaux.

Le principe est de capter notre attention grâce à des techniques d’influence automatisées (estime de soi, valorisation notamment via les icônes à pouces, commentaires, partages…), nous sommes incités à rester et revenir le plus possible sur les sites, plateformes, applications que nous utilisons. Avec en corolaire : addiction, trust exponentiel de données, incitation aux jeux… Les géants de la Tech sont les champions en la matière. Depuis quelques années déjà, ils ont modélisé cette « économie de l’attention ». Une économie en plein essor, dont les premières « victimes » sont notamment les jeunes.

Le principe est de capter notre attention grâce à des techniques d’influence automatisées (estime de soi, valorisation notamment via les icônes à pouces, commentaires, partages…), nous sommes incités à rester et revenir le plus possible sur les sites, plateformes, applications que nous utilisons. Avec en corolaire : addiction, trust exponentiel de données, incitation aux jeux… Les géants de la Tech sont les champions en la matière. Depuis quelques années déjà, ils ont modélisé cette « économie de l’attention ». Une économie en plein essor, dont les premières « victimes » sont notamment les jeunes.

L’éthique des Intelligences Artificielles, un grand défi de la société du XXIè siècle

– Hi, cKiou aimerait bien que les Humains trouvent les bons comportements à adopter avec mes congénères. Ce serait triste un monde sans vous ! Déjà que, comme on l’a vu, les usages numériques ne sont pas innocents face au réchauffement climatique… il vaudrait mieux que nos algorithmes servent à vous rendre la vie meilleure !

– Hi, cKiou aimerait bien que les Humains trouvent les bons comportements à adopter avec mes congénères. Ce serait triste un monde sans vous ! Déjà que, comme on l’a vu, les usages numériques ne sont pas innocents face au réchauffement climatique… il vaudrait mieux que nos algorithmes servent à vous rendre la vie meilleure !

– C’est gentil, ma petite cKiou. Pour cela, le deal est simple : soit donner raison aux prophètes de l’apocalypse digitale, soit rendre hommage à l’espèce humaine qui, depuis deux mille ans, a su se préserver malgré et avec les évolutions technologiques. Mieux, qui a su grandir avec elles !

L’éthique des Intelligences Artificielles, une chaine de valeurs

Heureusement, de plus en plus de voix considèrent l’éthique comme une valeur ajoutée susceptible de redonner aux Intelligences Artificielles à la fois du sens et de la confiance.

Des chercheurs, scientifiques et concepteurs d’IA misent sur l’éthique

Après le temps de l’euphorie débordante provoquée par les étonnantes capacités de l’IA, certaines dérives portées à la connaissance du monde sont venues calmer le jeu. De plus en plus de scientifiques, chercheurs et concepteurs veulent valoriser leurs travaux en mettant en avant une démarche axée sur l’éthique. Quelques exemples (je ne peux les citer tous) :

![]() Dès 2019, les Applied Machine Learning Days de l’École Polytechnique Fédérale de Lausanne : conscients de l’importance majeure de la notion de « l’utilisation à bon escient de l’IA », l’EPFL a sollicité des orateurs capables d’une prise de recul face aux avancées de ces technologies, comme le directeur de recherche au laboratoire d’IA de Facebook, qui avait conclu son intervention en soulignant « l’importance de la confiance, de la sécurité et de la transparence ».

Dès 2019, les Applied Machine Learning Days de l’École Polytechnique Fédérale de Lausanne : conscients de l’importance majeure de la notion de « l’utilisation à bon escient de l’IA », l’EPFL a sollicité des orateurs capables d’une prise de recul face aux avancées de ces technologies, comme le directeur de recherche au laboratoire d’IA de Facebook, qui avait conclu son intervention en soulignant « l’importance de la confiance, de la sécurité et de la transparence ».

![]() Au sein d’Allistene (Alliance des Sciences et Technologies du Numérique), une commission de chercheurs créée dès 2012, la CERNA, travaille sur l’adéquation possible entre principes éthiques et Intelligence artificielle.

Au sein d’Allistene (Alliance des Sciences et Technologies du Numérique), une commission de chercheurs créée dès 2012, la CERNA, travaille sur l’adéquation possible entre principes éthiques et Intelligence artificielle.

![]() Le SSRN (Social Science Research Network) vient de présenter une meta-analyse qui compare les contenus de 36 documents traitant de l’éthique de l’IA. L’analyse détaille les similitudes et les différences d’interprétation et relève que malgré la grande diversité d’approches des textes comparés, il se dégage de l’ensemble un consensus autour de 8 facteurs clés majeurs comme le contrôle humain de la technologie, la responsabilité professionnelle et la promotion des valeurs humaines !

Le SSRN (Social Science Research Network) vient de présenter une meta-analyse qui compare les contenus de 36 documents traitant de l’éthique de l’IA. L’analyse détaille les similitudes et les différences d’interprétation et relève que malgré la grande diversité d’approches des textes comparés, il se dégage de l’ensemble un consensus autour de 8 facteurs clés majeurs comme le contrôle humain de la technologie, la responsabilité professionnelle et la promotion des valeurs humaines !

8 facteurs clés pour une IA éthique

– vie privée

– responsabilité

– sûreté et sécurité

– transparence et explicabilité

– équité et non-discrimination

– contrôle humain de la technologie

– responsabilité professionnelle

– promotion des valeurs humaines

Les pouvoirs publics et les institutions s’engagent sur la voie de l’éthique

De même, de plus en plus d’institutions se montrent elles aussi soucieuses des questions d’éthique pour les Intelligences Artificielles. Juste quelques exemples :

![]() La Commission européenne fait plancher un groupe d’experts afin de présenter « des directives éthiques pour une intelligence artificielle digne de confiance ». Résultats attendus mi-février, mais elle donne déjà des lignes directrices pour une IA fiable :

La Commission européenne fait plancher un groupe d’experts afin de présenter « des directives éthiques pour une intelligence artificielle digne de confiance ». Résultats attendus mi-février, mais elle donne déjà des lignes directrices pour une IA fiable :

– Être licite : respectant toutes les lois et réglementations applicables

– Être éthique : respectant des principes et valeurs éthiques

– Être robuste : à la fois d’un point de vue technique tout en tenant compte de son environnement social

![]() De son côté, le Conseil de l’Europe, dans le cadre de la Commission européenne pour l’efficacité de la justice (CEPJ) a produit une « charte éthique européenne d’utilisation de l’intelligence artificielle dans les systèmes judiciaires et leur environnement » autour de 5 principes :

De son côté, le Conseil de l’Europe, dans le cadre de la Commission européenne pour l’efficacité de la justice (CEPJ) a produit une « charte éthique européenne d’utilisation de l’intelligence artificielle dans les systèmes judiciaires et leur environnement » autour de 5 principes :

– respect des droits fondamentaux

– non-discrimination

– qualité et sécurité

– transparence

– maîtrise par l’utilisateur

![]() La Cnil a aussi produit un rapport : « Comment permettre à l’Homme de garder la main ? Les enjeux éthiques des algorithmes et de l’intelligence artificielle ». Elle préconise notamment de « Former à l’éthique tous les maillons de la chaîne algorithmique (concepteurs, professionnels, utilisateurs) », et pas uniquement ceux qui touchent les données.

La Cnil a aussi produit un rapport : « Comment permettre à l’Homme de garder la main ? Les enjeux éthiques des algorithmes et de l’intelligence artificielle ». Elle préconise notamment de « Former à l’éthique tous les maillons de la chaîne algorithmique (concepteurs, professionnels, utilisateurs) », et pas uniquement ceux qui touchent les données.

Les entreprises comptent aussi sur une IA éthique

Les entreprises ont conscience que l’IA est devenu un enjeu business. De nombreuses études indiquent qu’environ les trois-quarts des applications d’entreprises utiliseront l’Intelligence Artificielle d’ici 2021. Or, actuellement un peu plus de 50% des dirigeants estiment ne pas pouvoir faire confiance à l’Intelligence Artificielle.

Or, depuis l’émergence du concept d’expérience utilisateur (UX) dans les années 90, la notion de « confiance client » s’est imposée comme un élément essentiel à toute stratégie d’entreprise. Notion incompatible avec l’actuelle réputation d’opacité de l’IA. Les entreprises sont donc conscientes que pour bénéficier des applications nourries à l’IA, elles ne peuvent pas faire l’économie d’un élément concurrentiel majeur : leur capacité à démontrer (pas seulement à dire) comment les algorithmes traitent les données qu’ils utilisent (clients, collaborateurs, partenaires…).

L’élaboration de principes éthiques s’impose donc au cœur de tout projet d’IA comme enjeu concurrentiel, dans le respect des intérêts des utilisateurs et d’un principe de vigilance.

Le Syntec Numérique et le Cigref proposent un guide opérationnel destiné aux professionnels de l’économie numérique : « référentiel pratique éthique et numérique »

Intelligences Artificielles & citoyenneté « penser éthique » à tous les cyber-étages

– Hi, cKiou est impressionnée par l’ensemble des acteurs de la société qui sont engagés dans une réflexion sur l’éthique. Tu crois que ça va aboutir à des mesures concrètes ? Parce que c’est ça qu’il faut pour être efficace, non ?

– Hi, cKiou est impressionnée par l’ensemble des acteurs de la société qui sont engagés dans une réflexion sur l’éthique. Tu crois que ça va aboutir à des mesures concrètes ? Parce que c’est ça qu’il faut pour être efficace, non ?

– Oui cKiou, soyons optimistes ! La nature humaine a su traverser deux millénaires en améliorant sa condition jusqu’à se doter des Intelligences Artificielles. Comme pour toutes les espèces animales grégaires, certains individus développent un instinct de survie qui leur permet de détecter les dangers. D’autres se mettent en situation de veiller sur la sécurité du troupeau. Ceux-là devront effectivement prendre des mesures concrètes, ne serait-ce que pour que les IA ne soient pas « le progrès de trop » pour le genre humain !

L’Éthique avant le Marché

C’est compliqué mais pas désespéré !

Sundar Pichai, le boss d’Alphabet (maison-mère de Google) déclare aspirer à une intelligence artificielle régulée. Il dit vouloir placer l’éthique avant le marché : « Il nous incombe de nous assurer que la technologie est guidée par le bien commun et disponible pour tous »

Intelligence collective, sans délire ni déni, pour relever ce grand défi du XXIè siècle

Si les Intelligences Artificielles sont capables du meilleur pour l’Humanité dans des domaines comme la santé par exemple, elles sont également porteuses du pire. Donc pour que la société profite des avantages elle doit savoir se préserver des risques.

Face à l’emprise des Intelligences Artificielles au sein de la société, cela ne pourra se faire que grâce à un effort collectif. Sachons être, sans délire ni déni, chacune et chacun à partir de notre expérience, maillon d’un « réseau de neurones interactifs » que l’on appelle « intelligence collective » ! Certes l’exercice est difficile parce que l’on est rarement totalement « contemporain de son présent », que chaque civilisation a besoin de temps pour créer ses outils culturels.

Mais nous aurions gros à perdre à entrer dans une spirale « éthicosceptique » à l’instar des années sacrifiées pour la planète parce que des climatosceptiques n’avaient pas envie de rompre leurs habitudes, de sortir de leur zone de confort. Certes, il est vrai qu’avec l’IA, certains font aussi de l’éthicowashing pour se parer d’une belle image de marque. Mais attention à ne pas jeter le bébé avec l’eau du bain ! Les enjeux sociétaux ne peuvent être niés et comme les technologies sont fulgurantes, il y a urgence.

Toutes et tous : chercheurs, concepteurs, innovateurs, législateurs, médias, dirigeants, internautes… avons un rôle à jouer pour faire de ces technologies des outils utiles à tous et non une menace pour les Humains. Pouces et index aux claviers, cartes bancaires en main, nous pouvons utiliser nos voix, partager nos choix et privilégier les acteurs soucieux de respecter nos données, nos valeurs…

- Découvrir les premières étapes de la vie de cKiou

- Les contributions des marraines et parrains de cKiou

Et sur Twitter :

Pour ne pas manquer les prochains apprentissages de cKiou :

(les adresses e-mails ne sont ni affichées ni cédées à des tiers)

Bravo pour ce dossier qui permet enfin d’y voir clair. Au moins on comprend le rôle de l’éthique et les enjeux. Parce que c’est exact que l’intelligence artificielle ce n’est pas que bien pour les gens. Par contre je ne suis pas sûr que chacun peut avoir un rôle à jouer. En tout cas bravo.

@Hugo, merci. Pour répondre à votre doute sur notre pouvoir d’influence, je dirais qu’il est le même que celui qui a fait bouger les choses pour le climat. Les réseaux sociaux nous donnent le moyen d’exprimer un avis. Je recommande de le faire dans le respect et pas avec la violence qu’on y croise parfois.

Une autre force nous est donnée par nos choix, en privilégiant les entreprises et les marques qui seront capable de démontrer la transparence et l’éthique de leurs outils.

Certes, ce n’est pas absolu, mais les petits ruisseaux font les grandes rivières !

Vous avez raison ce n’est pas gagné mais je suis agréablement surprise de voir que de plus en plus de corps professionnels et institutionnels s’emparent de ce sujet. En tout cas merci et bravo pour cette étude très intéressante.

Merci @Léa pour votre appréciation. Cela m’encourage à poursuivre l’éducation de ma petite cKiou 😉 !