Geoffrey Hinton, chercheur à l’origine des robots conversationnels

10 ans plus loin, le chercheur s’inquiète de l’usage des IA génératives comme ChatGPT

10 ans plus loin, le chercheur s’inquiète de l’usage des IA génératives comme ChatGPT

De l’université de Carnegie Mellon à l’équipe de recherche Google Brain

Geoffrey Hinton est un chercheur canadien né en 1947. Après une licence de psychologie expérimentale, il se passionne, dès les années 70, pour l’Intelligence artificielle, et plus précisément pour les réseaux de neurones artificiels. Il voit déjà dans cette spécialité informatique la capacité d’apprendre aux machines à effectuer n’importe quelle tâche. Ses travaux de recherche s’orientent donc surtout vers l’apprentissage automatique et les capacités de la mémoire.

Dans les années 1980, il part enseigner aux États-Unis, dans la prestigieuse université privée spécialisée en recherche informatique « Carnegie Mellon ». Mais il s’inquiète de voir que ses recherches, financées par le ministère de la Défense, pourraient conduire à produire des « robots tueurs ».

Le chercheur décide alors de rejoindre l’université de Toronto au Canada où il est reconnu comme un grand spécialiste des neurosciences et des programmes d’intelligence artificielle.

Geoffrey Hinton, chercheur à l’origine des robots conversationnels comme ChatGPT et co-inventeur de l’algorithme t-SNE

Breaking news, 8 octobre 2024 : Geoffrey Hinton reçoit le Prix Nobel de Physique

Breaking news, 8 octobre 2024 : Geoffrey Hinton reçoit le Prix Nobel de Physique

Le Prix Nobel de Physique 2024 a été décerné à deux chercheurs : Geoffrey Hinton et John Hopfield, chacun pour leurs travaux concernant « l’apprentissage automatique » indispensable au développement de l’intelligence artificielle.

Dans son communiqué, le Comité du Nobel précise : « les deux chercheurs ont utilisé des concepts fondamentaux de la physique statistique pour concevoir des réseaux de neurones artificiels qui fonctionnent comme des mémoires associatives et trouvent des modèles dans de grands ensembles de données ».

De son côté, John Hopfield a donné son nom au « réseau Hopfield », un modèle de réseau de neurones récurrents à temps discret. C’est une mémoire associative qui peut stocker et reconstruire des images par exemple. Une forme mémorisée est retrouvée par une stabilisation du réseau, s’il a été stimulé par une partie adéquate de cette forme.

Geoffrey Hinton crée une startup de recherche baptisée DNNresearch

Geoffrey Hinton crée une startup de recherche baptisée DNNresearch

Dans le même temps, avec deux de ses étudiants, Ilya Sutskever (qui deviendra co-fondateur d’OpenAI, l’entreprise mère de ChatGPT) et Alex Krizhevsky, Geoffrey Hinton crée une startup baptisée DNNresearch pour approfondir leurs recherches en intelligence artificielle.

Cette startup s’intéresse en particulier à la reconnaissance vocale et à la compréhension de la vision et du langage par l’ordinateur. L’objectif est de « permettre aux machines de mieux comprendre ce que les humains essaient de dire ». Les chercheurs mettent au point des réseaux de neurones artificiels capables d’optimiser les calculs utilisés par les systèmes de reconnaissance vocale, de compréhension du langage et d’identification d’objets.

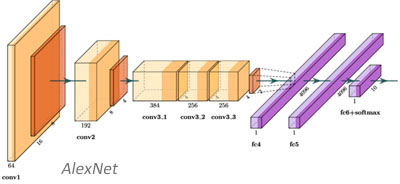

En 2012, ils développent notamment « AlexNet », une architecture de réseau de neurones convolutifs. Pour faire simple, les neurones artificiels y sont organisés en couches successives (5 couches convolutives et 3 couches associées) permettant de traiter les informations de façon progressive. Le système compte 62,3 millions de paramètres et nécessite 1,1 milliard d’unités de calcul par passage.

En 2012, ils développent notamment « AlexNet », une architecture de réseau de neurones convolutifs. Pour faire simple, les neurones artificiels y sont organisés en couches successives (5 couches convolutives et 3 couches associées) permettant de traiter les informations de façon progressive. Le système compte 62,3 millions de paramètres et nécessite 1,1 milliard d’unités de calcul par passage.

Il participe, en septembre 2012, au défi de reconnaissance visuelle « ImageNet », énorme base de données d’images annotées, destiné à la recherche en vision par ordinateur.

En 2013 Google rachète DNNresearch et Geoffrey Hinton rejoint Mountain View

En 2013 Google rachète DNNresearch et Geoffrey Hinton rejoint Mountain View

En mars 2013, attiré par les compétences des trois chercheurs dans le domaine des réseaux de neurones profonds, Google rachète DNNresearch. Ce rachat s’inscrit dans le prolongement de ses propres travaux. En effet, depuis 2011, Google s’était également lancé dans un projet d’apprentissage profond baptisé « Google Brain », lui aussi tourné vers la vision par ordinateur et la reconnaissance d’images.

Le professeur Geoffrey Hinton rejoint alors l’équipe de Google Brain. Cela ne l’empêche pas de poursuivre en parallèle ses recherches à l’Université de Toronto, et il espère du même coup leur donner plus de chances avec les capacités de calcul de l’entreprise de Mountain View.

Le professeur Geoffrey Hinton rejoint alors l’équipe de Google Brain. Cela ne l’empêche pas de poursuivre en parallèle ses recherches à l’Université de Toronto, et il espère du même coup leur donner plus de chances avec les capacités de calcul de l’entreprise de Mountain View.

![]()

Les principaux travaux de recherche de Geoffrey Hinton

Geoffrey Hinton s’intéresse principalement au domaine de « l’apprentissage profond », un des principaux ressorts de l’intelligence artificielle

– Application d’un algorithme de rétropropagation du gradient : méthode pour l’entraînement d’un réseau de neurones multicouches.

– Concept de réseaux de neurones à capsules (CapsNet), qu’il voit comme une avancée de l’apprentissage profond.

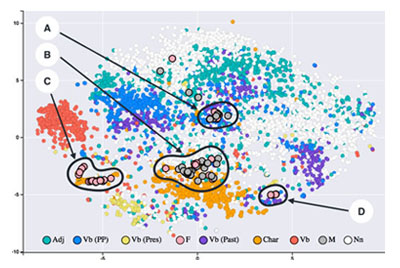

– Co-invention, avec Laurens van der Maaten, de l’algorithme t-SNE (t-distributed stochastic neighbor embedding), technique de réduction de dimension pour la visualisation de données. Il permet de « représenter un ensemble de points d’un espace à grande dimension dans un espace de deux ou trois dimensions pour une visualisation des données sous forme d’un nuage de points ».

Cet algorithme est utilisé notamment pour la recherche sur le cancer, la bioinformatique et le traitement de signaux biomédicaux. Il sert à la visualisation de représentations de haut-niveau apprises par un réseau de neurones artificiel

Prix Turing

Geoffrey Hinton reçoit le prestigieux « Prix Turing »

En 2018, Geoffrey Hinton reçoit le « Prix Turing », équivalent du « Prix Nobel » pour le monde de l’informatique. Ce prix vient récompenser ses travaux accomplis dans le domaine de l’apprentissage profond (deep learning).

Il partage ce prix avec deux autres sommités de l’intelligence artificielle :

– le Français Yann Le Cun, actuellement directeur de recherche IA de Meta, pour ses travaux permettant d’analyser les images et d’améliorer leur reconnaissance, en particulier son système de reconnaissance de l’écriture manuscrite.

– le chercheur québécois Yoshua Bengio, professeur au département informatique et de recherche opérationnelle de l’Université de Montréal. Également pionnier de l’apprentissage profond, il est récompensé pour ses travaux sur les performances des algorithmes de reconnaissance vocale et de traduction.

![]()

L’inquiétude de Geoffrey Hinton, à l’origine de la technologie de ChatGPT

Les travaux de Geoffrey Hinton se sont révélés essentiels, notamment dans le domaine de la compréhension du langage naturel mais aussi de la reconnaissance vocale et de la vision par ordinateur. Technologies au cœur d’OpenAI, entreprise qui a ouvert les portes à ChatGPT, le système conversationnel qui bouleverse nos usages numériques, et à DALL-E, système orienté « image » non moins impressionnant.

Selon Geoffrey Hinton, « Il est temps que l’on s’inquiète » !

Le chercheur, aujourd’hui âgé de 75 ans et surnommé « le parrain » dans le milieu de l’IA, a rendu publique son inquiétude sur le déploiement de ces IA génératives. Inquiétude qui l’a conduit à quitter Google pour qui il travaille depuis 2013 (voir ci-dessus) pour pouvoir évoquer librement ses craintes.

Les craintes de Geoffrey Hinton

Il évoque la vitesse croissante des progrès de l’intelligence artificielle et le fait que l’augmentation du nombre de données qui les entraînent (celles puisées dans nos interactions avec les systèmes) va encore augmenter cette accélération vertigineuse.

Il évoque la vitesse croissante des progrès de l’intelligence artificielle et le fait que l’augmentation du nombre de données qui les entraînent (celles puisées dans nos interactions avec les systèmes) va encore augmenter cette accélération vertigineuse.

La course engagée entre les big tech (Microsoft, Google, et autres) pousse aussi cette accélération mais aussi du même coup le risque de propagation de fake news qui deviennent de plus en plus difficiles à détecter. Il explique que « sans régulation mondiale, cette course ne s’arrêtera pas et qu’il sera difficile d’empêcher que ces technologies soient employées à des fins malveillantes ».

Autre crainte selon lui, largement exprimée dans les médias, une menace pour le marché de l’emploi et un risque sur certains métiers comme par exemple les interprètes et traducteurs, les journalistes, les illustrateurs ou encore des fonctions de codage informatique.

![]()

Le regard de cKiou

La parole est à la défense !

– Hi, cKiou est bluffée par le parcours de Geoffrey Hinton ! Si ça se trouve, sans ce grand chercheur, je ne serais pas ici, à discuter avec mon auteure Françoise Halper et les autres Humains !

Comme à l’arrivée de toute grande innovation, les avis sont partagés. Si certains sont d’emblée enthousiastes, elle doit franchir trois étapes : être d’abord perçue comme ridicule, puis dangereuse et avant de devenir évidente.

Aujourd’hui, les perceptions de l’intelligence artificielle se partagent surtout le terrain de l’enthousiasme et de l’inquiétude, comme Geoffrey Hinton.

Pour « donner la parole à la défense », on peut citer Yann LeCun, directeur de recherche IA de Meta, et qui a également contribué aux technologies qui sous-tendent les IA génératives.

Pour « donner la parole à la défense », on peut citer Yann LeCun, directeur de recherche IA de Meta, et qui a également contribué aux technologies qui sous-tendent les IA génératives.

Par exemple, sur l’une des craintes qu’elles pousseraient des métiers à disparaitre, il explique : « ce que ces machines vont permettre, c’est à une catégorie plus large de personnes d’être créatives, au niveau artistique ou technique. Ce qui va entraîner une espèce de démocratisation de la création. Mais les métiers de la création, qu’elle soit artistique, littéraire, scientifique ou technique, ne vont pas disparaître. Simplement, plus de gens vont être capables de créer ».

Et plus globalement, il pense que ces systèmes vont « amplifier l’intelligence humaine comme les machines amplifient la force physique ». Pour autant, il souligne également les questions d’éthique liées aux usages de l’intelligence artificielle et le besoin de réglementation.

Rien n’est à craindre, tout reste à comprendre !

Françoise Halper dirait certainement que ces deux points de vue sont indispensables à l’avenir de l’Humanité, surtout qu’ils se rejoignent sur la nécessité de régulation « pour garder le meilleur et éviter le pire ».

Elle évoque parfois l’essayiste George Bernard Shaw qui disait que « optimistes et pessimistes contribuent autant à la société. Le premier invente l’avion, le second le parachute » et Marie Curie qui a dit que « dans la vie rien n’est à craindre, tout est à comprendre » !

← Autres publications →

Et pour ne pas manquer la suite de l’Histoire du numérique…

(les adresses e-mails ne sont ni affichées ni cédées à des tiers)

Un grand chercheur qui a contribué à changer le monde.

Un grand créateur qui se méfie de ses inventions, c’est surprenant mais préoccupant !

@Franck Consola, exact on n’est pas habitué à ce qu’une technologie échappe si vite à ses pères ! L’Histoire avait coutume de prendre son temps, généralement plusieurs générations.